#1

TV 속 말을 주문으로 오판한

아마존 알렉사 신뢰도에 흠집

#2

구글-애플, 광범위한 대화 저장

문맥 추측해 적절한 답변 내놔

“사람과 AI의 진정한 대화는

짧은 시일 내에 힘들 것” 전망

올해 1월 미국 텍사스주에 사는 매건 나이젤의 딸(6)은 쇼핑 기능이 포함돼 있는 아마존의 스마트홈 시스템 에코에 “인형의 집과 놀게 해줄 수 있니?”라고 물었다. 에코에 탑재된 음성인식 인공지능(AI) 알렉사는 그 말을 듣고 바로 인형의 집과 쿠키를 주문해 집으로 배송했다. 더 큰 일은 그 다음이었다. 캘리포니아주 샌디에이고의 지역방송인 CW6뉴스에서 앵커 짐 패턴이 인형의 집 오배송 사건을 언급하며 “알렉사에게 인형의 집을 사달라고 말하다니 참 사랑스러운 아이네요”라고 말하자, 뉴스를 틀어놓은 집에 있던 에코들이 앞다퉈 인형의 집을 주문해 버린 것이다. 아마존은 잘못 주문된 인형의 집을 전액 환불하겠다는 방침을 밝혔지만, 알렉사의 신뢰도에 흠집이 간 것이 더 큰 타격이었다.

“나 피곤해”라는 말에 음성인식 AI로부터 “좀 쉬세요. 건강이 먼저라는 거 잊지 마시고요”라는 위로를 받을 때는 가족보다 낫다는 착각마저 들지만, 이런 오주문 사례를 보면 AI에 회의가 든다. 전문가들은 “음성인식 AI가 사람 말을 이해하는 것은 아니다”라고 말한다.

천차만별 발음ㆍ어휘 학습해 인식률 높여

소음 속에서 사람의 언어만 걸러내 듣는 것부터, 사람과 기계가 소통하기까지 난제는 한두 개가 아니다. 기가지니를 개발한 박재형 KT AI디자인팀장은 “음악 등 잡음은 마이크에서 사람 음성만 증폭시키는 방식으로 걸러낸다”고 설명했다. SKT 누구를 개발한 김영준 음성인식기술팀장은 “사람 명령어가 나오기 전의 배경 잡음을 미리 분석해 두었다가 전체 소리에서 잡음을 빼는 방법도 있다”고 소개했다. 그러면 아마존 에코는 왜 TV 소리를 사람 음성으로 착각했을까. 김 팀장은 “전자장비의 자체 스피커에서 나오는 소리는 AI가 쉽게 구분하지만, 외부에서 들리는 말 소리는 구별하기 어렵다”고 설명했다.

잡음이 없다면 사람마다 천차만별인 발음을 범주화해 음소를 파악하는 것이 음성인식의 출발점이다. 음성인식 AI는 사람의 말소리를 ‘ㄱ’ ‘ㅏ’와 같은 음소 단위로 인식한다. 성별이나 톤에 따라 주파수 절대 수치는 다르지만, 음소 고유의 패턴이 식별된다. 음소를 결합해 음절을 인식하고 다시 단어를 완성한다.

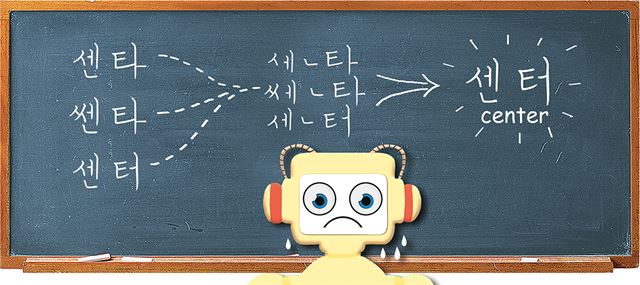

단어 수준부터는 주파수 분석 이상의 많은 것이 필요하다. 사람이라면 ‘센터-센타-쎈타’라는 발음을 한 단어로 받아들이고, ‘궁물’을 ‘국물’로 이해하는 게 쉽지만 기계에겐 그렇게 지당한 일이 아니다. 한국어의 복잡한 발음규칙 장벽을 넘어 ‘궁물’을 ‘국물’로 인식하도록, AI 개발자들은 사전을 통째로 입력시킨다. 이에 더해 현실에서 통용되는 다양한 발음과 어휘를 AI에 학습시킨다. 알파고가 1,000년이 걸릴 대국 빅데이터를 학습해 이기는 전략을 스스로 배웠듯, 다양한 발음들이 같은 단어임을 배우게 하는 것이다. 김 팀장은 “각 가정에서 누구와 대화한 건수가 하루 평균 50만 건, 지금까지 1억 건이 수집됐는데 이를 다시 누구에게 학습시키고 소프트웨어 업데이트를 통해 기능을 향상시킨다”고 설명했다.

AI 대화의 관건은 문맥 추측

단어가 인식되면 문장 수준에서 말한 이의 의도를 파악해야 하는데 조건을 맞춰 말하면 AI의 인식률은 높아진다. 김 팀장은 “‘대통령을 포털에서 찾아 줘’라고 말했을 때, 사람이 원하는 포인트는 ‘대통령’ ‘검색’ ‘포털’이라는 3개다. 문장이 바뀌어도 이 3개가 명확하면 인식 가능하다”고 설명했다. 하지만 같은 질문이나 마찬가지인 “대통령 누구야?”는 AI가 이해 못할 수 있다.

문제는 사람이 통상 대화할 때 여러 단어들을 생략하고 앞뒤 맥락에 의존하며 억양과 표정 등 비언어적 수단도 활용한다는 사실이다. 육동석 고려대 컴퓨터공학과 교수는 “사람은 대화 전체의 문맥을 이해하기 때문에 단어가 한두 개 빠져도 의미를 추측할 수 있지만, AI는 사고의 복잡성이 사람보다 크게 떨어져 추측이 불가능하다”며 “사람과 AI의 진정한 대화는 짧은 시일 내에는 힘들 것”이라고 전망했다.

구글 어시스턴트나 애플 시리는 상대적으로 광범위한 대화 히스토리를 저장해 문맥을 추측해 질문의도를 파악하고 적절한 답변을 내놓는 편이다. 박재형 팀장은 “기가지니의 경우 직전 대화만 이해하고 답변하는 정도지만, 앞으로 장기 대화 히스토리를 저장해 문맥을 추측하는 방향으로 나아갈 것”이라고 말했다. 궁극적으로는 사용자 개인의 대화를 저장ㆍ분석해야 AI의 소통능력이 대폭 향상된다.

사람의 말을 이해한 뒤 어떤 답을 내놓을지는 AI의 알고리즘 작동에 달려있다. 음성인식 AIㆍ스마트홈 개발업체 싱크스페이스의 송철호 대표는 “수많은 답변 리스트 중 질문에 적합하지 않은 가지를 배제하고 적합한 가지를 선택해 점차 선택지를 좁혀 최적의 답변을 찾는다”고 설명했다. 그는 “AI 디자이너가 하는 일이 바로 무수한 답변 목록을 분류하는 작업인데 디자이너의 설계에 따라 AI의 인식률에 크게 차이가 난다”고 말했다. 송 대표는 “디자이너는 언어학자일 수도 있고 공학자일 수도 있다. AI 개발이야말로 인문학과 공학의 경계가 허물어지는 지점”이라고 덧붙였다.

박재현 기자 remake@hankookilbo.com

기사 URL이 복사되었습니다.

댓글0